近期,中国科学院合肥物质院智能所谢成军与张洁团队将多模态融合方法应用于遥感图像全色锐化领域,相关研究成果以“Exploring Text-Guided Information Fusion Through Chain-of-Reasoning for Pansharpening”为题发表在地球科学和遥感领域的中国科学院一区Top期刊IEEE Transactions on Geoscience and Remote Sensing (IEEE TGRS)上。

遥感图像全色锐化技术旨在融合低分辨率的多光谱(LRMS)图像与高分辨率的全色(PAN)图像,以生成兼具高空间分辨率和丰富光谱信息的遥感影像。尽管由文本引导的多模态学习方法在自然图像领域已经取得了显著进展,但由于全色锐化领域多模态数据集的缺乏,以及遥感场景的复杂性等问题,为语义信息的准确提取带来了巨大挑战。

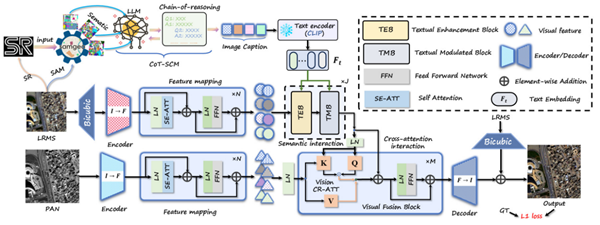

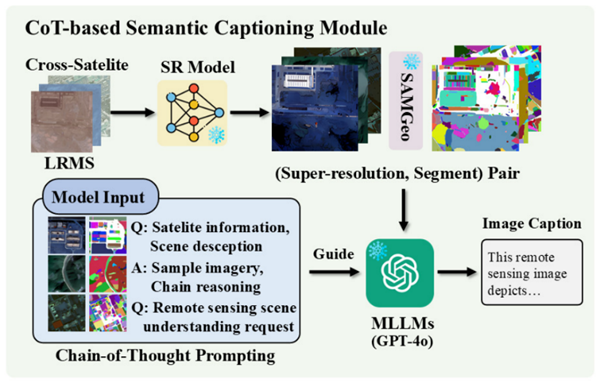

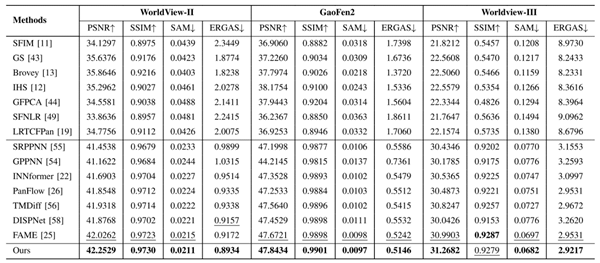

为解决上述挑战,研究团队提出了一种创新的文本引导多模态融合框架(TMMFNet)。该框架首先基于多模态大语言模型(MLLMs),结合超分辨率模型、地理空间分割模型以及思维链(CoT)提示技术,为LRMS图像生成高质量的语义描述文本,从而构建了面向全色锐化的多模态遥感数据集。此基础上,团队设计了文本增强模块(TEB)与文本调制模块(TMB)两个核心融合单元,能够将文本中所蕴含的高层语义信息有效注入融合网络,从而引导并优化视觉特征的融合过程。在WorldView-II、GaoFen2和WorldView-III等多个公开卫星数据集上的实验结果表明,所提方法在峰值信噪比(PSNR)和结构相似性(SSIM)等关键评价指标上均表现出优越性能。

硕士生李薛恒为论文第一作者,谢成军研究员、张洁副研究员为论文通讯作者。该项工作得到了安徽省自然科学基金、合肥市自然科学基金项目的支持。

论文链接:https://ieeexplore.ieee.org/abstract/document/11145881

图 1 基于视觉-文本多模态融合的遥感图像全色锐化网络

图 2 多光谱影像语义描述生成方法

表1 模型在不同数据集下的实验结果

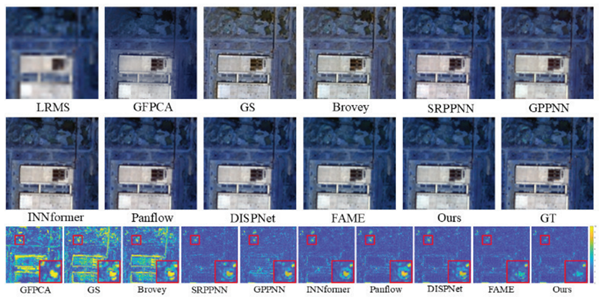

图 3 不同全色锐化模型在WorldView-II数据集上的实验结果比较